大数据中心一般包含IDC机房、综合机房等,机柜密集度高,机柜发热量极大。空调系统既需要满足电子信息设备的散热要求,还需要保证供冷系统的可靠性。此外,数据中心能耗较大,需要尽可能降低能耗。

目前行业主流的制冷方案是冷冻水和蒸发冷却技术方案,其他制冷方式只有一些零星试点,几乎没有大规模应用案例。因此本文将通过两种制冷系统形式的比较,为数据中心建设之初制冷和空调方案的选择提供思路。

冷冻水系统属于传统系统,已经规模应用了十年以上,但近年来新建或待建的数据中心项目,则更多采用了蒸发冷却空调AHU的方案。

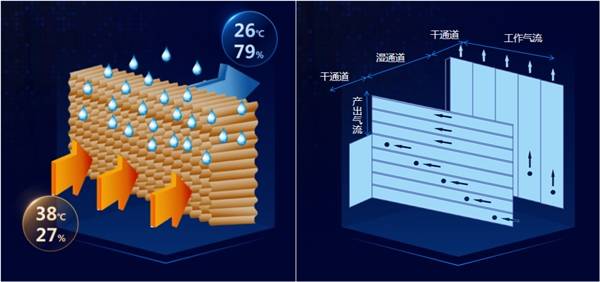

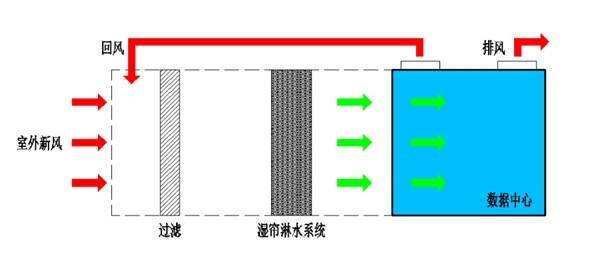

澳蓝直接蒸发技术

充分利用干空气能的一种技术,利用不饱和空气的干球温度与湿球温度之差作为驱动势进行降温冷却,空气越干燥,干湿球温差越大,蒸发冷却的驱动势越大,蒸发冷却效果越好。

澳蓝间接蒸发技术

空气首先进入芯体的干通道,同时一部分被冷却后的气流通过孔口进入另一侧的湿通道。湿通道中空气和喷淋水在水蒸气分压力差的驱动势下,进行热湿交换。

露点间接蒸发效率接近100%,若再进行直接蒸发冷却,理论上总湿球效率将达到130%。

从可靠性来看,AHU方案可用性更高。

理论上,各种空调方式都能满足国标ABC级相关要求,也能实现Uptime Institute TIER Ⅰ/Ⅱ/Ⅲ/Ⅳ规规定的可靠性功能,能够实现不间断供冷。但相较冷冻水系统,AHU方案更简单,可能的故障种类少,故障影响范围小,维护的用时也会更短,因此拥有更高的可靠性。冷冻水系统,一旦出现冷冻站着火或主管路故障,就有可能发生整个系统崩塌的大范围故障,这类故障影响范围大,修复也需要更多的时间。

从节电维度看,AHU方案用电更少,更符合绿色数据中心的建设要求。

间接蒸发冷却系统即使在炎热的夏天,也能有一半以上的负荷可以通过自然冷却(蒸发冷却)带走,自然冷却的利用更充分,可以大幅降低数据中心制冷系统能耗,在全国绝大多数地区的PUE基本介于1.15-1.3之间。间接蒸发冷却全年只有部分时间需要用水,用水量远低于水冷冷冻水系统,同时设备可以选择节水或节电模式运行,可基于IT负载和资源情况,实现制冷量与资源情况匹配。传统冷冻水方案无法全年利用自然冷却,存在完全机械制冷工况,在绝大多数地区,机械制冷的应用时间都比较长,PUE没有优势。

从施工运维看,AHU方案更加灵活,便于项目分期建设。

AHU机组单个设备就是一个制冷单元,设备的集成度高,可以根据项目建设需求进行部署,整体建设周期短,后期运维也较简单。系统的架构简单,设备种类单一,没有复杂的管路,需要现场安装的工程量少,安装调试也相对简单,交付周期短。并且可以根据业务需要分期灵活扩容,扩容时也不会对已经运行的设施造成不利影响。这些优点是冷冻水系统无法比拟的。

随着数据中心规模和数量的几何增长,以及国家能源战略政策的密集出台、双碳目标计划的实施和对数据中心PUE值的强制限制。充分利用自然冷源,引进新技术,降低能耗,提升系统能效,成为数据中心迫切需要解决的问题。

由于蒸发冷却系统的绿色节能、安装便捷、运维简单等特点,近几年该种制冷形式在国内数据中心的建设中得到广泛应用。

EN

EN